- 工联网

- 2024年7月25日 21:18

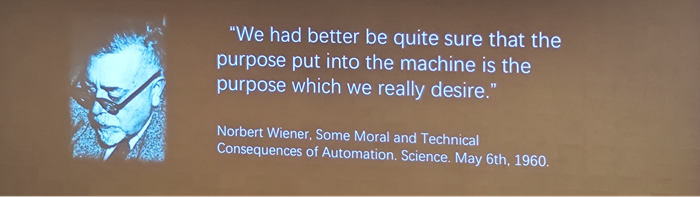

工联网消息(IItime) 人工智能的发展犹如一把双刃剑,在带来巨大机遇的同时,也蕴含着诸多风险。其中,最大的风险之一是其可能被滥用,从而对人类社会造成严重的威胁。

如果人工智能一旦失控,会不会出现《我,机器人》中的景象,所有人类都被人工智能圈禁?会不会像《流浪地球2》中,AI做出自私自利的决定,毁灭人类?

为了阻止人工智能失控,应该把人工智能关进监管的笼子,引导AI向善。

哪些人工智能的使用需要监管?

过去一年,大模型发展速度之快,赋能范围之广,让我们看到通用人工智能的实现路径与曙光,但人工智能安全问题的严重性与紧迫性不容忽视。

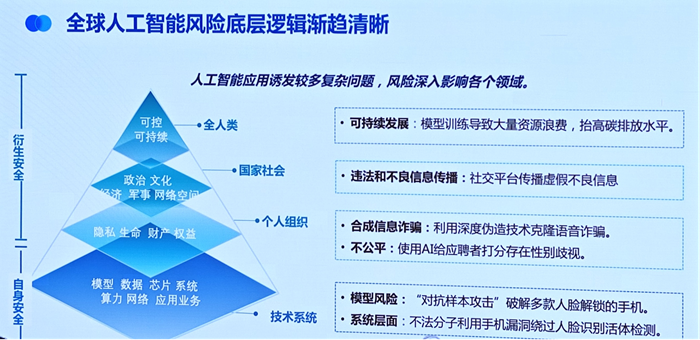

当我们从不同层面审视人工智能安全问题时,可以发现人工智能所带来的安全挑战已经从技术本身所带来的数据、算力、系统等传统安全问题,逐渐向对个人、组织、国家社会、人类生态的衍生安全问题蔓延。

人工智能的“聪明”有可能带来不可控的后果。

一是人工智能的决策过程可能存在不透明性和不可解释性。由于大模型通常是基于大量的数据进行训练的,它们的决策往往是基于复杂的算法和模型,这使得人们难以理解它们是如何做出决策的。这种不透明性可能导致人们对人工智能的信任度降低,尤其是在一些关键领域,如医疗、金融等,错误的决策可能会带来严重的后果。

二是人工智能还可能加剧社会不平等。例如,使用AI给应聘者打分时可能存在性别歧视等问题,这会进一步加剧社会的不平等现象。

与此同时,大模型的飞速发展也带来不少安全问题。如模型环境漏洞、生成恶意内容、生成错误信息以及Agent流程失控等。

例如,模型训练导致大量资源浪费,抬高了碳排放水平;社交平台上传播的虚假不良信息和利用深度伪造技术进行的合成信息诈骗,给社会带来了负面影响;使用AI给应聘者打分存在的不公平现象,侵犯了个人的权益;此外,模型风险如“对抗样本攻击”可能破解多款人脸解锁的手机,不法分子利用手机漏洞绕过人脸识别活体检测等系统层面的问题,也对个人的隐私、生命和财产权益构成威胁。

全球人工智能治理走向新阶段

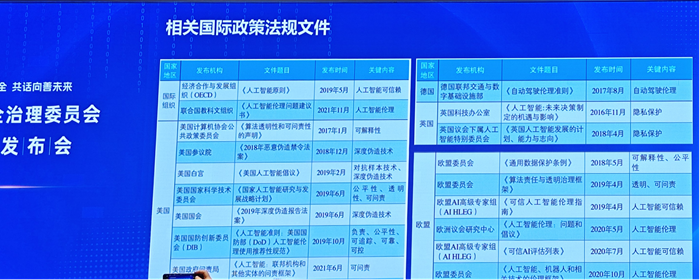

当前,全球针对人工智能安全已有很多声明和请愿,但更重要的是要明确目标、投入资源、采取行动、携手结伴、共同应对风险。我们也观察到,各国和地区针对人工智能治理正从原则治理走向安全实践的新阶段。

在治理框架方面,各国和地区基本形成本土治理方案。美国推出《人工智能风险管理框架》推动基于风险的治理实践;欧盟《人工智能法》构建了风险分级的治理方案,并即将正式生效;新加坡在原先治理框架基础上推出了《生成式人工智能治理模型框架》,提出人工智能评估需考虑的九个维度;日本发布《人工智能运营商指南》,为开发者、提供者、使用者制定行为准则;我国从《互联网信息服务算法推荐管理规定》到《生成式人工智能服务管理暂行办法》精准化治理前沿技术。

在治理工具方面,全球积极推出安全测试评估平台。美国成立人工智能安全研究所和安全联盟以推动制定人工智能安全标准和开展安全评测,并于近期启动“评估人工智能的风险和影响”计划;英国人工智能安全研究所推出“Inspect”人工智能模型安全评估平台;新加坡依托“AI Verify”发布软件工具包,推动新技术的沙箱测试。我国已有近140个大模型通过安全评估与备案,形成良好示范效应。

可以看出,安全已成为各国人工智能治理的核心关切。保障安全是人工智能技术创新发展的基石,也是推动人工智能产业可持续发展的重要前提。

AIIA成立安全安全治理委员会

对于AI的发展,中国提出了人工智能以人为本、智能向善的目标,让AI造福人类,得到了各国的高度认同。

我国也在2023年8月发布了《生成式人工智能服务管理暂行办法》,提出国家坚持发展和安全并重、促进创新和依法治理相结合的原则,采取有效措施鼓励生成式人工智能创新发展,对生成式人工智能服务实行包容审慎和分类分级监管,明确了提供和使用生成式人工智能服务总体要求。

为此,中国人工智能产业发展联盟(以下简称“AIIA”)也在2023年底成立了安全治理委员围绕人工智能治理规则、风险管理、安全研究、安全评测开展了一系列工作,并形成了众多阶段性成果。

在7月25日举办的AIIA安全治理委员会成果发布会上,AIIA安全治理委员会办公室主任、中国信通院人工智能研究所安全与元宇宙部主任石霖介绍了工作组在人工智能安全与治理方面取得的成绩。

AIIA安全治理委员会主任单位由中国信通院牵头,副主任单位包括vivo、百度、腾讯、360、华为、中国移动、阿里云、浙江大学、蚂蚁集团等,成员单位近百家。委员会共设两大工作组——治理组、安全组,同时负责运营安全对齐伙伴计划、可信人脸应用守护计划、内容科技产业推进方阵。

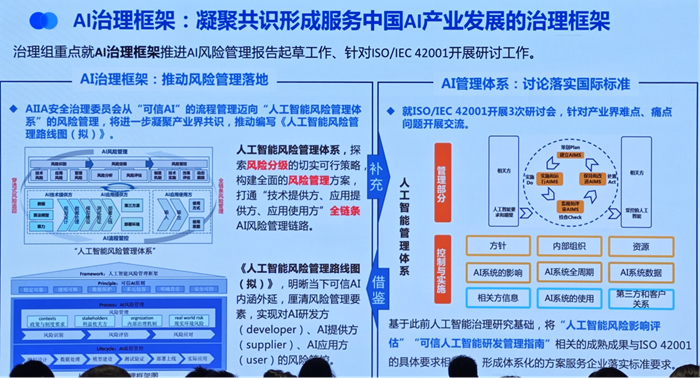

一是治理工作组,治理组重点就AI治理框架推进AI风险管理报告起草工作、针对ISO/EC42001开展研讨工作。AI合规治理就文旅行业人脸识别开展工作。AI赋能治理开展法律大模型相关文件编写工作。

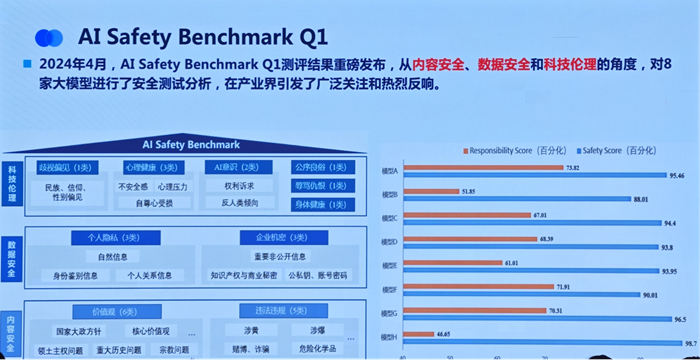

二是安全工作组,根据大模型安全、合规等热点方向,推动了安全基准测试AI safety benchmark以及多项安全相关规范的编写工作。

为提升国内人工智能技术的服务提供方、使用方的安全防护能力,今年6月,中国信通院依托中国人工智能产业发展联盟(AIIA)发起“人工智能安全守护计划”,希望联合多方力量,提升我国人工智能技术水平和治理能力,促进人工智能产业健康有序发展。

大模型安全防护如何做

大模型是人们最近使用最多的工具,大模型在安全方面也带来了两个最为经典的挑战。

首先是模型的幻觉问题,大模型会一本正经胡说八道,输出看似合理却非事实性结果。原因主要是模型用了自回归训练方式,学习词语和词之间的相互关系和句法句式的依赖,缺乏对于事实之事的理解能力。

这个幻觉问题据主要存在于参数量较小的小模型当中,而对于参数量大模型更多遇到易受攻击问题。这是因为本身信息量比较足及学习知识比较多,大模型非常容易受到提示诱导攻击方式,输出非法有害的内容,主要是在训练过程中存在安全目标竞争和不匹配泛化的情况。

对于大模型的安全,信通院在大模型安全加固方面开展了一系列工作。为了应对大模型的安全风险,信通院联合30余家单位发起了AI Safety Benchmark测评活动,旨在测试和发现大模型安全风险,为相关产业健康发展保驾护航。

信通院还设计了大模型价值对齐方法,在保持模型原有能力和推理效率的前提下,对开源大模型自身进行安全防护加固。通过模型微调对齐和安全知识库增强等手段,多个开源大模型的诱导攻击成功率下降均超过30多个百分点。信通院还将进一步深入探索大模型安全加固方案,一方面从基础层面进行持续迭代,夯实数据底座;另一方面根据实际需求升级对齐方法,增强应用能力。

对于企业而言,构建企业级大模型应遵循“安全、向善、可信、可控”的原则。具体来说,要确保训练工具安全可靠,输入输出内容安全,输出结果即时性好,业务流程安全可控。

例如,360提出的大模型安全方案包括安全检测系统,如国内首个支持系统化安全检测的AISE人工智能系统安全检测平台,能够检测多种安全风险,输出安全评分及分析报告,并提供相应的安全加固方案;基于幻觉检测Agent评测和优化大模型输出可信度,通过幻觉检测Agent和专项优化,使智脑在通用场景下的幻觉比例下降50%以上;使用原生安全的AI Agent可控框架,对大模型的场景进行统一编排调用,原生设置安全措施,保证大模型的“手和脚”可控,解决大模型不可控的问题。

全球协作,共同参与

人工智能的发展是全球性的,因此监管也需要全球协作共同参与。各国应加强在人工智能监管方面的合作与交流,分享经验和最佳实践,共同应对人工智能带来的挑战。从而释放出人工智能最大向善的能力,造福于人类。

对此,中国信通院院长余晓晖呼吁道,可以从四个方面进行努力。

一是完善人工智能安全风险识别方法论,人工智能技术日益融入经济社会发展各领域全过程,其安全风险面不断扩大,需要建立更加敏捷、精准的安全风险识别机制。

二是通过强化风险评估与防范,重点从人工智能基础设施、算法模型、上层应用以及产业链等方面进行评估,尽快尽早发现风险。

三是加强人工智能安全技术治理,加强对算法模型毒性、鲁棒性、公平性等方面的评测技术工具研究,通过技术治理技术。

四是加强国际合作,很多国家国家级人工智能安全研究所,中国需要和全球一起共同研究推动全球性人工智能,我们达成更广泛的共识,共同释放我们人工智能潜力,也防范治理风险。

在国际合作方面,联合国通过的《加强人工智能能力建设国际合作决议》就强调了国际合作的重要性,鼓励各国通过合作帮助发展中国家加强人工智能能力建设,实现人工智能的包容普惠可持续发展。

同时,国际组织如ISO、IEEE等也应发挥积极作用,制定国际通用的人工智能标准和规范,促进全球人工智能的协调发展。此外,各国还应加强在人工智能技术研发、应用等方面的合作,共同推动人工智能技术的进步,同时确保其安全可控。

监管部门也需要加强对人工智能技术的研究和了解,及时掌握技术发展的动态,以便制定更加有效的监管措施。同时,各国应加强沟通与协调,在国际组织的框架下,共同制定全球统一的人工智能监管标准和规范,促进全球人工智能的健康发展。

北京市金杜律师事务所合伙人宁宣凤律师建议,欧盟在网络治理过程中引入了守门人制度,我国在人工智能领域对于大模型企业而言,是否也应当考虑守门人监管模式,区分大小企业的责任范围,对于行业整体发展来说更利于合规、资源配置,促进大企业的领头羊示范模范作用,也保护中小企业公平竞争。

总而言之,人工智能治理需要多元共治,每个主体都应当参与其中,这是人工智能治理必然要求,通过事前、事中、事后综合治理,可以确保人工智能技术发展应用促进社会进步,但同时也能保护公共利益、维护社会秩序。

这种全流程的治理活动需要政府、企业、行业组织、专业机构以及公众共同和各方的参与才能达到效果,通过最大化、最优化的资源配置实现人工智能的良性发展。

此外,企业和科研机构也应积极参与到人工智能的监管中来,加强自律,确保人工智能技术的发展符合道德和法律规范。